AI模型掀起“大小之争”,谁将取胜?

【ZiDongHua 之智能自动化收录关键词:大模型 AI 人工智能 ChatGPT 】

AI模型掀起“大小之争”,谁将取胜?

过去一年,大模型因其惊人的创造力和广泛的适用性成为全球瞩目的焦点,每次迭代更新都牵动着市场的心弦。与过去各大厂商在各自领域不断迭代的小模型相比,大模型凭借其强大的泛化能力和丰富的生成内容,令人们深思:大模型能否全面取代小模型,成为赋能生产、生活的唯一工具?

从“小作坊”到“流水线”,大模型让 AI 研发更简单

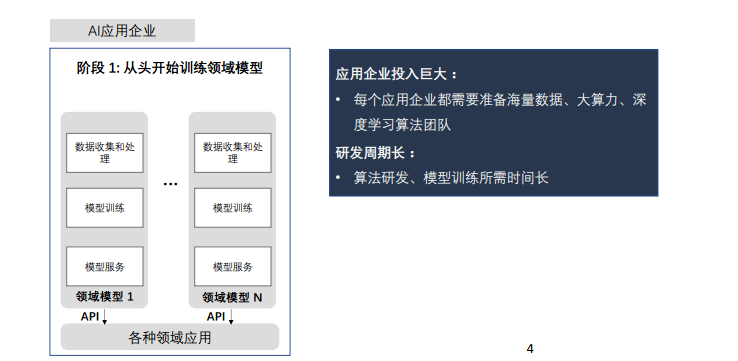

在大模型兴起之前,AI 研发的第一阶段范式是“从头开始”,每个模型都针对特定应用场景需求进行训练。这一阶段需要优秀的产品经理给出准确需求,并投入巨量资源,包括高质量的训练数据、强大的算力,以及具备扎实专业知识和协同合作能力的深度学习算法团队。然而,这种传统的定制化、作坊式的模型开发方式导致小模型无法复用和积累,使得 AI 落地面临高门槛、高成本和低效率难题。

资料来源: 2023•黑马AIGC峰会 智源研究院

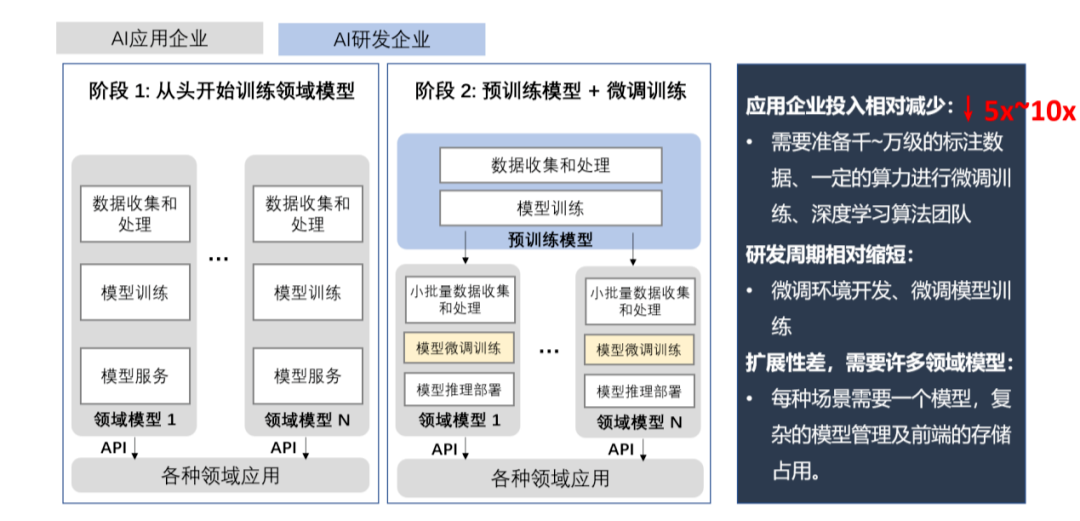

2014年,预训练模型+微调的迁移学习技术的出现,成为了 AI 研发的第二阶段范式。该范式主要利用训练好的基础预训练模型,进行二次微调训练。相较先前的范式,能够节省5-10倍的人力、算力和数据量。然而,此方法扩展性不佳,模型难以跨领域或场景泛化。在复杂场景下,需要训练多个模型。

资料来源:2023•黑马AIGC峰会 智源研究院

近几年来,大模型技术的发展让 AI 研发进入第三阶段范式,即基础大模型+应用提示。亿级参数以上的大模型能从各种场景数据中提炼出通用能力,形成具有泛化能力的模型底座。通过直接调用 API,大模型能快速输出所需结果,不再需要微调训练。这使得 AI 研发更加高效,模型生产从“作坊式”升级为“流水线”。因此,许多研究力量开始集中于大模型,认为它能全面赋能生产生活。

事实上,仅靠基础大模型+应用提示并不能满足产业落地需求。实践证明,对于特定或新任务,即使通过多轮提示让大模型输出所需结果,它仍“记不住”过程。若将完整提示加到每次调用中,可能超出大模型上下文能力,且导致推理开销增大、效果难以控制。

不仅如此,大模型+应用提示的数据来源往往是公开资料,质量低、专业度不足,有时甚至会给出错误或误导性信息,更适用于泛化能力要求高、通用能力要求高、精度要求低的广域场景。而在精度要求高、泛化能力要求低的窄域场景中,大模型+应用提示可能无法提供足够的竞争力。

此外,很多实际任务和特定场景缺乏充足的数据,或者并不需要大量数据。当面对少量标注数据时,大模型容易过拟合,导致性能下降。同时,在计算资源有限的场景,如各类终端设备上,大模型的能力也受到限制。

在现有的技术条件下,单纯依赖大模型并不能解决所有问题。预训练小模型结合迁移学习训练的第二阶段范式,仍然在很多场景中发挥着不可替代的作用。

深耕细分领域,小模型的六大差异化优势

工信部数据显示,截至大模型爆发前的2022年,国内有近4000家 AI 企业分别在各自的领域内不断优化小模型。这些小模型已广泛部署于各个行业,显著提升了社会整体的生产效率。

2022年中国AI软件算法下游场景分布

与大模型相比,小模型的训练数据量与参数量较少,这为它带来了诸多差异化优势。

01

速度更快,效率更高

小模型需要的资源少,训练和预测速度快,能在配置低的硬件上运行;

02

具备灵活性和可定制性

小模型能适应各种场景,可以通过调整模型来提高准确率;

03

具备安全性和隐私保护能力

小模型处理的数据量小,不需要在云端处理,本地运行更安全;

04

资源消耗和成本低

小模型的存储和带宽需求少,成本低,适合在边缘设备上运行;

05

数据质量和数量要求低

小模型对数据要求不高,即便低质少量也可以使用;

06

易于部署和升级

小模型可以根据生产环境的需求进行调整。

如果说大模型的特点是“通用”,那么小模型的优势就在于“专精”,可以满足特定场景、特定任务的需求。以计算机视觉领域为例,小模型已在多个实际场景中实现商业化应用,包括泛安防(如人脸识别闸机)、互联网(如用户匹配)、金融(如身份核验)、工业(如缺陷检测)和医疗(如辅助诊断)等。

当前,从发展阶段来看,大模型在商业应用中的落地仍处在早期阶段,而小模型则占据市场的主导地位。大模型的优势在于其泛用性强,并能够基于用户反馈持续优化自身性能。相反,小模型虽然泛用性相对较弱,但却能填补行业落地"最后一公里"的需求空白。

在此背景下,以应用落地为核心诉求,大模型和小模型协同发展,或将成为未来一段时间内的主流趋势。

大小模型并驾齐驱,推动AI普惠加速落地

AI 的普及和实际应用,成本是核心问题。通过大小模型的协同并驱,可以更好地发挥各自的优势,从而实现成本的降低和效率的提高。

大模型的优势,在于其广泛适用性和自我优化能力,因此可以通过预训练和微调为企业定制百亿级大模型。同时,利用蒸馏和剪枝等技术,将大模型的知识和认知能力输出到小模型中,或从大模型中抽取十亿级小模型,以轻量化小模型向下游场景赋能。

小模型在行业实施中具有前瞻性,能加速大模型的收敛,并评估大模型的样本价值。其核心任务是将行业知识导入大模型。短期来看,小模型在行业应用中具有不可替代的地位,负责实际应用的推理与执行环节。基于真实场景数据的训练,小模型能向大模型反馈更具针对性的模型算法,从而提升大模型的能力。

资料来源:华东政法大学《人工智能通用大模型(ChatGPT)的进展、风险与应对》

作为智能行业的领军企业,联想早在去年就提出了混合智能(Hybrid AI)概念,认为混合智能将会在各行各业落地应用,推动 AI 普惠。联想混合智能是指大型的公共大模型和小型的企业级大模型、个人大模型的混合应用,共同构建一个混合 AI 框架,让企业和个人没有后顾之忧地享受大小模型带来的效率红利。

去年12月,联想又在与IDC发布的业内首份《AIPC产业(中国)白皮书》中表示,大小模型并用的混合 AI,对承载小型的“个人大模型”的终端的交互能力、智能算力、应用场景、安全保护等都提出了更高要求,PC 以各方面表现出的优异性能,成为AI普惠的首选终端。

与此同时,联想率先推出了全球首款 AI PC。基于在服务器领域的经验,以及“端、边、云、网、智”的新 IT 能力积累,联想的 AI PC 产品会搭载大模型压缩技术,从而具备本地运行“个人大模型”的能力,可以实现公共大模型与个人大模型两者间精准地实时切换。

在随后的几个月内,联想不遗余力的推出十余款 AI PC,加速 AI 在 PC 领域的应用和普及。此外,还发布了天禧AI生态“四端一体”战略,意在全面整合内嵌AI 技术的终端设备,让混合 AI 在更多终端普及。该战略中首次亮相的个人智能体,进一步优化了用户与 AI 的交互体验,让 AI 技术更贴近用户日常生活。

未来,联想将承担起行业生态组织者的使命,以场景需求为基础面向用户整合产业资源,继续探索小模型与终端设备的深度融合,对用户的体验“总负责”。

我要收藏

个赞

评论排行