专访|曾毅:人类应当充分反思跟上人工智能演化的速度

专访|曾毅:人类应当充分反思跟上人工智能演化的速度

作为今年以来最“出圈”的一项科技,生成式人工智能大模型吸引了全球的目光。对于AI(人工智能)将如何改变千行百业?人工智能是否已经拥有了科幻电影里超越人类的能力?人类如何应对AI的挑战?不乏有专家发表真知灼见。

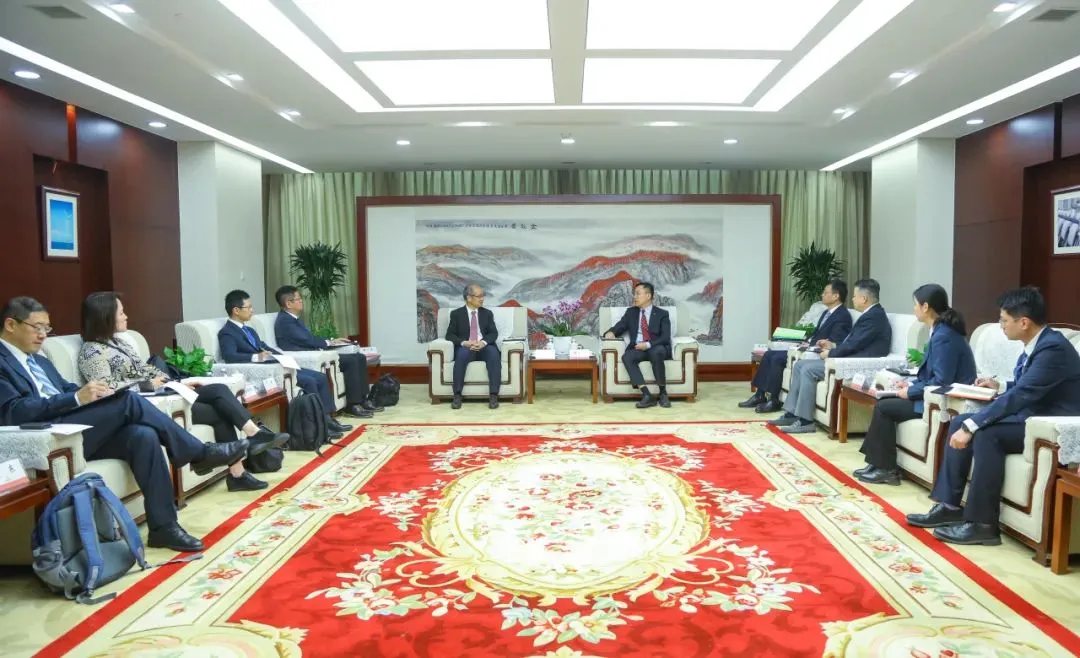

近日,新京报贝壳财经记者对曾在联合国安全理事会就人工智能议题发言,被《时代周刊》评为“全球百大AI人物”之一的中国科学院自动化研究所研究员、人工智能伦理与治理中心主任曾毅进行了专访。曾毅教授对当前AI大模型热潮下,人类在技术上是否可能触及通用人工智能,生成式大模型的发展可能会对社会造成何种影响,以及如何看待当前国内AI大模型“百模大战”态势等多个问题进行了回应。

曾毅认为,当前阶段的人工智能是“看似智能的信息处理工具”,距离真正拥有意识的通用人工智能还有相当距离。人工智能所带来的问题并不仅仅是科学、技术和产品层面的,还有社会层面,人类应该对此做好准备。对于生成式人工智能大模型存在的重大问题,曾毅认为伦理安全隐患是目前最不可忽视的,必须为每一个介入社会应用的人工智能服务构建伦理安全框架,用“教育大模型知善知恶、为善去恶”的方式来解决。而在人才培养方面,人工智能人才不应该只聚焦于算法算力相关人才培养,社会学、人类学、心理学,甚至哲学、伦理等都应当纳入未来人工智能体系的培养中。

谈入选

人工智能不仅是科学问题,还是社会问题

新京报贝壳财经:此次你被《时代周刊》评为“全球百大AI人物”,与你同时入选的还有马斯克、黄仁勋、李彦宏、李开复等业界知名人士,你怎么看待这项荣誉?

曾毅:被评为“全球百大AI人物”是直接通知结果的,《时代周刊》八月份给我发了一封邮件,告诉我入选了,其实入选前没有给《时代周刊》提交过任何材料。我入选的是“思想者(Thinker)”系列,觉得也是一个长期积累的过程,应该是对我和我的团队开展类脑人工智能及人工智能伦理与治理研究和实践的认可,出现在这个名单中对我和团队在这个领域的耕耘是一份重要的鼓励。

就像斯皮尔伯格的电影《AI》中的情节,如果机器人能爱人,那人应该怎么做?这是一个社会问题。我曾被邀请参加了一次德国总统施泰因迈尔访华时的小型研讨会,在这一过程中我提问,德国人工智能伦理是由科技部门制定还是其他部门制定?对方回答:伦理问题是一个社会问题,因此在德国制定人工智能伦理规范时,进行的是社会辩论,在社会场景下讨论这个问题。

这说明,人工智能本身起源于一种科学畅想,但在大规模应用于社会时,它成为了一种社会赋能技术。然而,它不仅仅会赋能社会,还可能对社会产生负面影响,因此我们需要做好准备,不光在科学方面,还有社会方面,这需要在科技哲学视角作出深刻的思考作为指引。

此次入选“全球百大AI人物”,我最受益的地方是向其他99名入选者学习他们的思想和成就,在这之中不乏有人工智能学术界领先的学者和企业代表。在这99人里面,我发现几乎没有对人工智能在科技或应用方面的进展所造成的社会问题一点都不关注的。

入选者中,除了产业界和学术界的人物外,还有另外两类典型,是科幻作家和用人工智能进行艺术创作的引领者,其中科幻对未来提出了若干种可能性,对科学的发展毋庸置疑也是有启发作用的。所以反观100人的名单列表,我认为此次评选的作用不仅仅是对这100人的认可,更重要的是引起学术界、产业界、公众对未来的反思,所以我觉得应该从社会伦理等更多视角反思人工智能对当代社会和未来社会的意义,以及作为更长远的科学意义上的人工智能应当何去何从。

新京报贝壳财经:我们应该如何应对生成式人工智能大模型可能对社会造成的影响?

曾毅:人工智能目前已经快速演变为科技发展引起的社会问题,需要从社会层面去讨论,既不能停留在科学家的层面,更不能仅仅停留在人工智能相关产业层面去制定相关规范,必须有公众参与和政府引导。

目前,不论文字工作者还是艺术工作者都受到了人工智能不同程度的挑战。真正的智能实际上有两个因素很关键,一个是自我,一个是理解。任何一个文字工作者和艺术工作者,都对于社会、自然有基于自我的体验和理解。包括采访这件事情,记者的背景和兴趣不同,提出的问题也完全不同。现在的人工智能没有自我,当你在使用生成式人工智能大模型时,人工智能是在没有科学意义上“我”的概念前提下以“我建议、我认为”来与用户沟通,这其实在混淆人与现代人工智能之间的界限,目前的人工智能并非也没有能力作为责任主体,不能承担任何责任。

目前,人工智能创作有可能替代相对平庸的作品,但无法替代大师的杰作。因此,人工智能倒逼艺术工作者和文字工作者进行对艺术本质的反思,实际上提出了更高的要求,人工智能的发展应该让人类所从事的职业回归到正确的位置。

谈现状

现阶段AI大模型只是工具,距离通用人工智能还很远

新京报贝壳财经:今年以来,AI大模型热潮的一大讨论点是,我们目前是否已经实现了通用人工智能?对此你怎么看?

曾毅:我认为ChatGPT的成功跟当年深度学习的广泛应用非常相似,最本质的科学原理可能几十年前就已经存在,但如此大规模的数据支撑和计算体系结构对于训练大规模参数的人工智能引擎来说,在几十年前甚至5年前都难以想象。尽管科学原理相对清晰,但在用户体验层面,通过大规模的工程计算达到了前所未有的高度。

我们之前考虑,如果大规模的语料可以达到或近似整个人类互联网的规模,计算系统是否就真正能理解了人类的语言?从用户体验的角度来看,看上去似乎已经真正理解了,但从科学原理来说,它仍然是处理的过程。

目前的AI大模型,是一个看似智能的信息处理过程,但从它仍然会大规模地犯人类不犯的错误,就能够知道,它仍然是处理过程,而非真正理解。现在的人工智能并没有逃脱“看似智能的信息处理工具”这一阶段,当前并非人工智能的终极阶段。

生成式人工智能大模型或者基础模型,现在已经达到了多任务信息处理器的阶段,所以可以用它做很多任务,但当它泛化到新任务中,解决没有见过的问题的能力仍然是有限的。人类的认知功能有400多种,对于解决从未见过的问题,生成式人工智能大模型与人类复杂的认知功能,以及复杂认知功能产生的自组织相比,仍有较长的距离。

学术上,有很多研究者曾严肃评估过通用人工智能何时到来。平均来说,绝大多数人工智能学者认为,通用人工智能距离现在还有80年到90年,而机器人学者则认为需要将近100年。而谷歌和OpenAI都声明在10到15年实现通用人工智能,我觉得在这一时间段内可能会实现信息处理的通用平台,但要实现真正意义的像人类一样拥有自我、情感、意识的通用人工智能,我仍然并不乐观。

新京报贝壳财经:请展望一下人工智能大模型的未来,你认为AI大模型在人类社会未来的发展中将扮演什么角色?

曾毅:在当前阶段,包括一般企业所提到的基础模型和通用人工智能技术,它们的定位应该是未来具备理解能力的智能信息处理工具,能够更好地辅助人类。因此,我认为基础模型这块应该朝这个方向发展。

在日本、韩国以及部分中国文化背景中,尤其是日本的人工智能原则强调,未来人工智能可能扮演社会的准成员,甚至是人类伙伴的角色。日本的人工智能原则中最后一条规定,如果未来AI发展到准成员或人类伙伴阶段,它们需要遵守人类社会的伦理道德规范以及为人工智能制定的伦理道德规范。

而西方科幻中,人工智能扮演了很多反派的角色,是人类的敌人。所以AI大模型在未来的角色无非三种:工具、伙伴或者敌人。目前,通用的人工智能技术正在往工具方向走,也可能就停留在工具本身,社会的准成员、人类伙伴角色仍然在探索中,敌人则是我们最不想见到并且应当极力防范的。

未来社会的构成是随着自然演化生成的有生命的个体,以及随着人工智能演化生成的看似有生命的智能体构成的社会。在这个社会中,人工智能体与人类智能以及其他动物智能是否能够和谐共生,我认为最终并不一定取决于人工智能,而是取决于人类是否能够加速演化。

对于“加速演化”,我指的是在人类与生态关系认知层面的演化,比如实际上我们现在没有给超级智能任何有实际说服力的理由让它们来保护人类,同时现在人类对其他生命也没有足够的尊重。当人工智能视人类就像人类视蝼蚁一样时,人工智能保护人类的理由是什么呢?所以,未来共生社会的伦理体系需要重新塑造,我们现在认为自己是地球的统帅,但当超级智能的智慧水平超越人类时,我们与其他类型生命体交互和共生的方式可能需要发生改变。

我对人工智能演化的速度有信心,但对人类认知自然,与生态相处的方式演化的速度,我并不是很有信心,因为人类在历史上不断犯曾经犯过的错误,所以加速演化的人工智能应当促使人类社会在与生态中其他生命体的关系认知与实践方面加速演化。

谈发展

人工智能可提供更好交互服务,AI创造的红利应分配给被替代的人

新京报贝壳财经:当前,许多企业都表示将把大模型能力接入自己旗下的产品,对此你怎么看?

曾毅:从企业的角度来看,引入大模型的能力是否能为人们提供更便捷的服务和更好的用户体验,用户是最终的判断者。实际上,目前ChatGPT的用户数量正在逐渐缩水。从产业人工智能的角度来看,我认为人工智能发展的这一阶段不应该承诺太多。

另一方面,人们是否真的需要所谓的“机遇”?当大家谈论生成式人工智能可以写新闻稿时,作为一个人工智能研究者,我并没有动机关注它写的稿子。当一个记者进行实地采访时,他所选择的视角,传递的价值观是对社会的诠释。而现在的人工智能即便能达到“理解”事实的阶段,也只是对“事实”的反映,没有真正基于自身经验的体悟,价值观的反思,现在看人工智能写出的稿件,很难看到真正的“洞见”。

我们可以探索,让人工智能提供更好的交互式服务,我认为未来很多App可以有一个相对统一的接口,以交互式形式提供服务。当需求聚焦在某个领域时,它是一个“受限域”,信息处理的复杂度相对较低,而且生成式人工智能还在不断进步,在交互式服务方面取得更上一层楼的用户体验,我对这点充满信心。

但在大规模内容生产方面,我们还是要小心谨慎。有研究证明,当把人工智能生成的语料作为大数据训练的语料反哺人工智能训练时,模型性能会退化。我不太愿意看到互联网上充斥着大量人工智能生成的内容这也算是理由之一。

人工智能作为一种交互式手段,在内容生产过程中起到辅助分析、提供素材和骨架的作用,为文字工作者在基础阶段提供支撑,我认为这些都是好的。生成式人工智能目前可以作为辅助工具,但作为责任生产者,至少现阶段还“不够格”。

新京报贝壳财经:目前,一些行业已经应用了大模型的能力,如果未来人工智能大规模进入产业端并开始应用,可能对社会产生什么影响?

曾毅:从产业应用的角度,大家都在探索生成式人工智能的机遇,可以说从用户体验上若干个传统行业都已经达到了前所未有的新的体验,这是毋庸置疑的。但我想提到的是,人工智能在介入和服务社会时,我们要更及时地探索人工智能如何适度使用?哪些任务现在应当被人工智能所替代?是否没有任何风险?或者至少人工智能不犯人类也不会犯的错误。要替代,至少要确保在一般情况下比人做得好。如果达到这个条件,我觉得我们可以做一个探索,但由此也显然会引发社会问题。

当大规模替代影响了人类劳动,此时人工智能所创造的红利是被应用人工智能技术的企业所占有,还是被人工智能公司所占有?还是说一部分红利应该分配给被替代的人?这就变成了问题。

当人工智能进行劳动替代时,必须进行基于数据的训练,这些数据大多数来自传统行业的人工的行为或思维输出。当你利用大规模收集的数据训练人工智能时,实际上这些数据对人工智能的启发都来自于数据贡献者。但是现在似乎没有一个合理的形式,反哺被替代的人的贡献,比如我们现在录一个小时的数据用于大规模数据训练,最终一个小时要给你100块钱或1000块钱。但训练成功后,你失去了未来的工作。

在这种情况下,人工智能红利的分配是否合理?在我看来,现在社会还没有准备好,所以人工智能的应用机遇确实达到了前所未有的阶段,但对于社会的挑战也是前所未有的。当我们的社会没有准备好时,人工智能绝对不能无所不在,应当适度使用。

谈问题

应通过伦理安全框架“教育”大模型善恶是非

新京报贝壳财经:今年7月你所在的团队发布了“智善?如流”人工智能伦理道德与社会规范的群智数据与知识平台,现在已经两个多月,用户有什么反馈?

曾毅:科学界在AIGC的发展浪潮中需要与公众在一起为人工智能把脉、把关,发声并引导人工智能健康稳健发展,我们希望人工智能可以“从善如流”,所以我们创造了一些手工编写的场景并在此基础上用AIGC创造相似的场景,随后邀请人和机器人判断这些场景是否合乎道德,当前有数万种场景以及互联网上用户的判断。

目前有两类反馈很有趣,一类是学术界和产业界问所有结果能否开源,对此我的回答是肯定的,因为平台存在的目的就是为了推动人工智能朝着合乎伦理的方向发展。另一类反馈是,觉得我们很多场景似乎并不是在讨论机器人的行为道不道德,而是在某些场景下人的行为道不道德,这是因为目前人工智能基础模型提供的服务主要针对人与人之间交互的世界,机器人需要清楚人如何与人交互,目前机器需要首先更为系统化地掌握人类伦理。

很多问题都出现在人工智能场景下,如果机器人这样做是否合乎道德,大家看得很准确。我们有些问题关注机器人如果做得是这样,是否优先考虑道德问题,即如果人这样做是否合乎道德。目前人工智能基础模型提供的服务主要针对人与人之间的交互世界。我认为,“智善?如流”的工作就是人类的一面镜子,反映了人类社会的道德和伦理规范。我们邀请很多人为输出行为打分,很多人的行为实际上是冲突的,并不一致,特别是在文化背景不同时,冲突会更明显。

新京报贝壳财经:目前,许多大模型已经面向公众开放,对于人工智能生成的内容存在的“幻觉”问题,以及大模型有可能遭到诱导输出不适宜内容等现象,你认为应该如何解决这一问题?

曾毅:所谓的基础模型输出呈现“幻觉”的问题实际上反映出的还是模型没有真正的理解能力,也对于“事实”没有合理的认知,在这种情况下将神经网络与经典的知识表示与推理、知识验证等技术结合,一定可以在处理的层面更上一层楼,但是要本质解决这个问题,还是要突破真正的“理解”。对于安全隐患的问题,目前已经向公众开放的大模型在安全和价值观对齐方面都做了一些工作,但实际上更多的像打补丁一样,对漏洞进行封堵。用户如果换一种方法提问,大模型可能仍然会遭到诱导。因此,使大模型的输出合乎伦理道德是非常必要的。

有些人希望从基础数据训练上解决问题,构建一个干净的数据集,用这些数据训练大模型就能解决问题,但我认为这并不完全可行,因为未来很多生成式模型都会接入互联网数据,一旦与互联网数据结合,由于没有教大模型知善知恶,它就会利用互联网数据,再生成回答,这样可能导致前端数据过滤部分的工作收效甚微,真正的人工智能模型就像培养孩子一样,在接触社会,与人交互时,社会存在偏见,但它无法分辨。

在下一个阶段,我们需要像给小学生上道德与法制课一样,让大模型经历知善知恶的过程。智能引擎未来不能只是数据处理工具,还必要内置伦理安全框架,在接触外界时,伦理安全框架会发挥作用。这可以理解为用一个规模不大的、学习伦理道德的神经网络,在外围发挥指引作用,从而引导规范内部行为。包括在大模型学习和处理数据阶段,道德模型也应该发挥作用,分析哪些是应该学习的,哪些是不应该学习的。

谈创新

大模型人才教育体系应培养“文理兼修的人才” ,发展大模型科学界与企业界要各司其职

新京报贝壳财经:对于目前人工智能的人才培养现状,以及大模型热潮下人才应如何跟上产业发展,你有何意见和建议?

曾毅:我认为现在的人工智能人才的培养可能在过早的阶段过于专业。在我上学时还在计算机科学与技术系,在信息处理、软硬件体系、信号处理等基础上有广泛的培养。虽然这样的培养仍然不够,我认为一个坚实的基础对未来从事多学科交叉是很有好处的。

不过,计算机科学与技术构造的是计算系统,是一个工具,但未来人工智能赋能社会发展,可能会介入社会的各个方面。因此,在人才培养方面,我们需要补充几个短板。例如在社会学、人类学、心理学,甚至哲学、伦理等都应当纳入未来人工智能体系的培养中。未来的人工智能创新者,需要“文理兼修”。

我认为当代人工智能从业者,包括本科、硕士和博士的教育,从智能本质的认知方面,需要对认知心理学、神经科学等有充分理解。对于社会的影响,需要科技伦理或专门的人工智能伦理课程,这些恐怕都是未来人工智能教育中不可或缺的部分,所以我不建议过早地,聚焦于只做算法和硬件体系研究。

新京报贝壳财经:你怎么看待目前人工智能领域的国际竞争,以及英伟达A100等人工智能训练用的芯片被“禁售”的情况?

曾毅:未来,人工智能必须进行软硬件协同创新,才能发挥其真正优势。在我国的创新体系中,我们必须从最初的人工智能模型算法跟踪或创新,快速过渡到实现软硬件协同创新,从软件、硬件的相对独立发展,到人工智能赋能的发展时代打造面向人工智能的软硬协同的“智件”。在基础设施方面,许多企业希望通过不同渠道汇集更多芯片,我认为现在应该采取两方面努力,首先是应用现成的国外硬件体系,短期的商业服务还可以去做。但一定要以壮士断腕的决心,从现在开始布局全国产化的基础模型体系。我们之前在很多事情上吃过亏,所以我认为这事没有商量余地,未来软硬件需要协同设计,这也是这个时代发展“智件”的科学性所必须的,所以很有必要发展全栈自主的基础模型体系。

我认为,国内目前绝大多数大模型还谈不上真正意义的创新,绝大多数的努力还是在工程优化方面。因此,未来在提升基础模型应对复杂问题的泛化性方面,要真正做到数据规模能耗更小,却表现出更高的智能。在模型算法结构和体系上实现协同创新,而不仅仅是提升用户体验方面,这还需要一系列努力去做。

这时候需要分工,科学界应该关注大的科学问题和体系化发展协同创新的问题,企业则关注规模化创新和用户体验的提升,二者要协作起来。现在高校科研机构已经推出了许多大模型服务,但一旦发展到用户体验这个阶段,就目前的技术发展阶段,还无法逃脱掉“有多少人工就有多少智能”的阶段,这不是科学界的重点工作,所以我认为,科学界和企业要各司其职,相得益彰,协同发展。

受访者简介:

曾毅

中国科学院自动化研究所研究员、类脑认知智能研究组负责人、脑图谱与类脑智能实验室副主任、人工智能伦理与治理研究中心主任;中国科学院大学岗位教授、博士生导师;远期人工智能研究中心主任;中国人工智能学会心智计算专委会主任;国家新一代人工智能治理专委会委员;联合国教科文组织人工智能伦理特设专家组专家。研究方向为:类脑人工智能、人工智能伦理、治理与可持续发展。被美国《时代周刊TIME》评为人工智能最具影响力100人。

是类脑认知智能引擎“智脉(BrainCog)”开源平台的负责人(http://brain-cog.network),在人工智能伦理方面,从事有道德的人工智能模型研发,主持了链接人工智能原则平台(www.linking-ai-principles.org)、人工智能治理公共服务平台(www.ai-governance.online)、面向可持续发展的人工智能智库(https://ai-for-sdgs.academy)的研发,是《人工智能北京共识》、《面向儿童的人工智能北京共识》、《和谐人工智能原则》、《面向生物多样性保护的人工智能原则》、《面向气候行动的人工智能原则》等伦理原则的责任起草者。代表性成果发表在PNAS、Cell Press旗下期刊Patterns、iScience,Nature出版社旗下Scientific Data、Scientific Reports、Humanities and social sciences communications,以及Science出版社旗下Science Advances、IEEE Transactions、Neural Networks以及人工智能领域重要国际会议NeurIPS、IJCAI和AAAI等。

类脑认知智能实验室

类脑认知智能实验室(BrainCog Lab)隶属于中国科学院自动化研究所,实验室成立于2013年,是从事类脑人工智能前沿理论和脑与智能交叉创新的研究团队。由中国科学院自动化研究所脑图谱与类脑智能实验室副主任曾毅研究员担任团队负责人。

类脑认知智能实验室以构建面向通用人工智能的类脑认知智能模型与应用为主要研究内容,特别是在类脑脉冲神经网络学习、发育与演化机理、类脑可塑性理论体系、类脑知识表征与推理、类脑决策理论、意识计算模型、情感与伦理道德的类脑模型等方面开展研究。

实验室研制的类脑认知智能引擎“智脉(BrainCog)”致力于为新一代人工智能前沿探索打造基于脉冲神经网络的通用人工智能引擎,服务于人类与人工智能的和谐共生。

远智观点(Views on Long-term AI)关注人工智能伦理与治理近期与长远发展的理论研究、观点分析与实践,旨在培育领域前瞻思想,促进国内、国际观点对话与交流,助力领域共识、规范与政策的形成。主要涉及近期与长远人工智能的风险与挑战、人工智能伦理与治理理论与实践、通用人工智能与超级智能的发展途经及其社会影响、国防人工智能与军控、人工智能促进世界和平、人工智能助力可持续发展。

研究中心

中国科学院自动化研究所人工智能伦理与治理研究中心是从事人工智能伦理与治理,符合伦理道德的人工智能模型与应用、人工智能可持续发展与治理研究的智库与科技创新深度融合的综合性研究中心。中心作为代表性机构参与国内外人工智能伦理与治理原则、规范的形成与实施;开展人工智能内生安全、符合伦理道德的人工智能模型与应用研究;对人工智能伦理、治理与可持续发展的近期与长远科学挑战开展前瞻研究。

中心长期参与国家有关部委、国际组织的人工智能伦理与治理相关研究工作,参与编写《国家新一代人工智能治理原则》、《国家新一代人工智能伦理规范》、《联合国教科文组织(UNESCO)人工智能伦理问题建议书》、《世界卫生组织(WHO)健康领域人工智能伦理指南》。研制并发布了“链接人工智能准则平台”、“人工智能治理公共服务平台”、“面向可持续发展的人工智能智库平台”等一系列人工智能可持续发展与伦理治理交叉研究与服务平台。

中心与国内外相关机构及各国学者、产业代表共同发起的面向可持续发展的人工智能协作网络(AI for SDGs Cooperation Network)是促进人工智能赋能实现可持续发展目标,以及人工智能的发展与治理深度融合创新的国际合作网络。

我要收藏

个赞

评论排行